Usi e abusi delle immagini generate con l’IA

Qualche mese fa ho scritto un pezzo sui programmi di intelligenza artificiale testuale e sulla scarsa affidabilità che avevo riscontrato nel momento in cui chiedevo a quelle applicazioni informazioni molto precise, specialmente in ambito artistico. La situazione non è molto migliorata: le risposte continuano a essere imprecise e prolisse, deragliando spesso nel non-richiesto. Ecco uno dei tanti esempi.

La domanda era semplice e chiara, a prova di malintesi. Eppure l’IA ha ritenuto di aggiungere informazioni non pertinenti omettendo invece una risposta utile: tra gli esponenti del Futurismo morti prima del 1954 c’è anche Luigi Russolo, famoso per la macchina intonarumori e per i suoi dipinti dedicati al dinamismo e alle percezioni sensoriali.

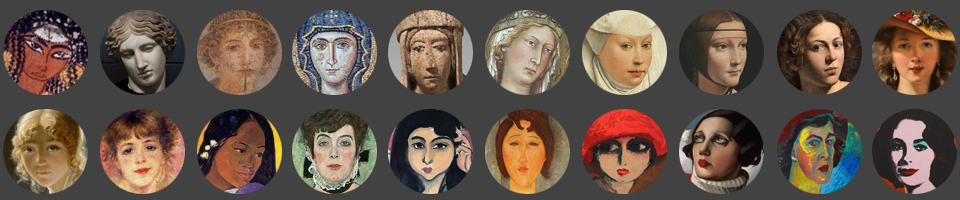

Ma non era di questo che volevo scrivere oggi bensì delle immagini generate con l’IA. Nello stesso articolo, infatti, avevo aggiunto delle illustrazioni che avrebbero dovuto rappresentarmi intenta a lavorare ma che alla fine non mi somigliavano per niente!

La delusione, però, è stata mitigata dall’osservazione di alcuni utilizzi dell’IA generativa interessanti e divertenti.

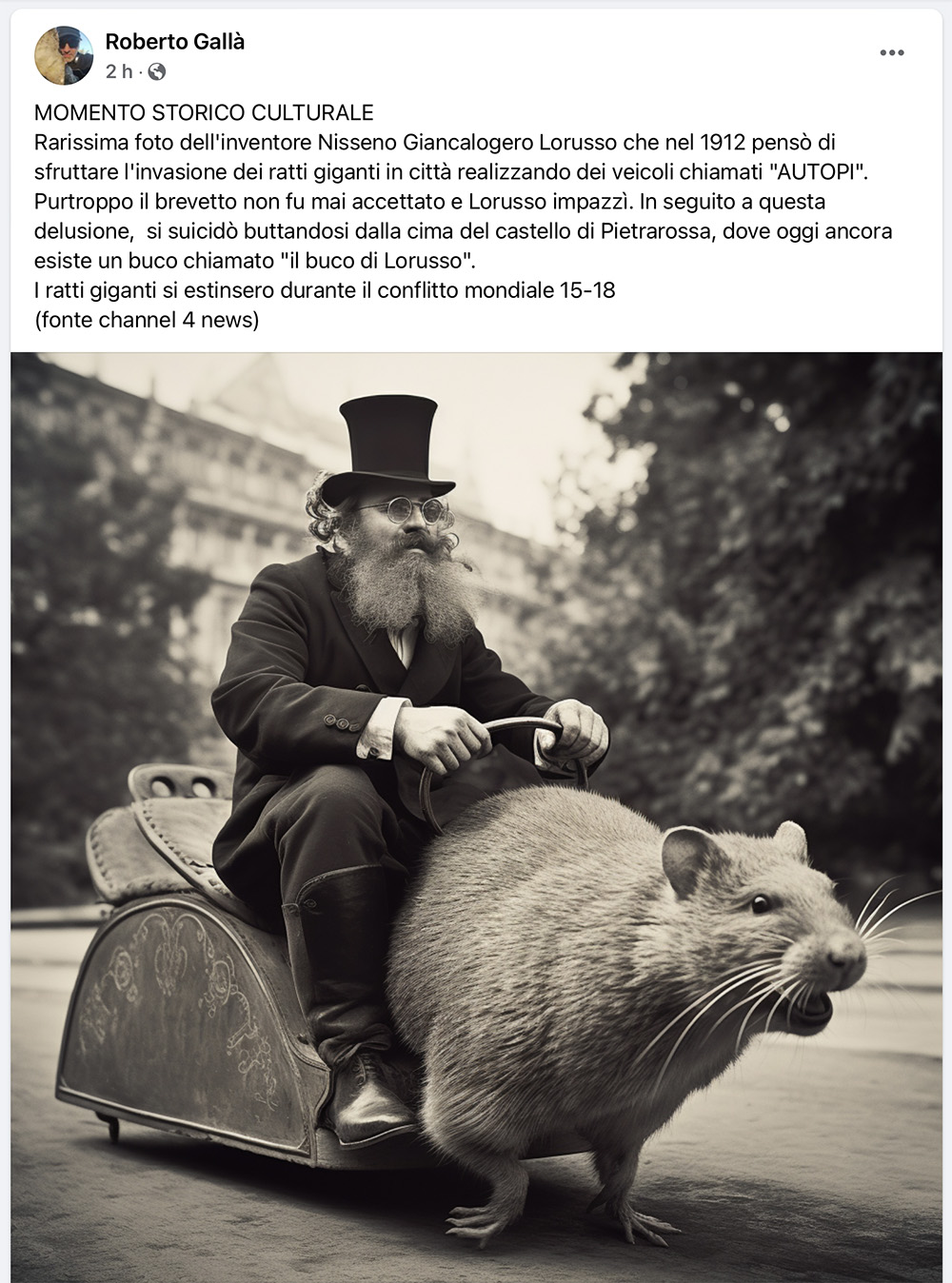

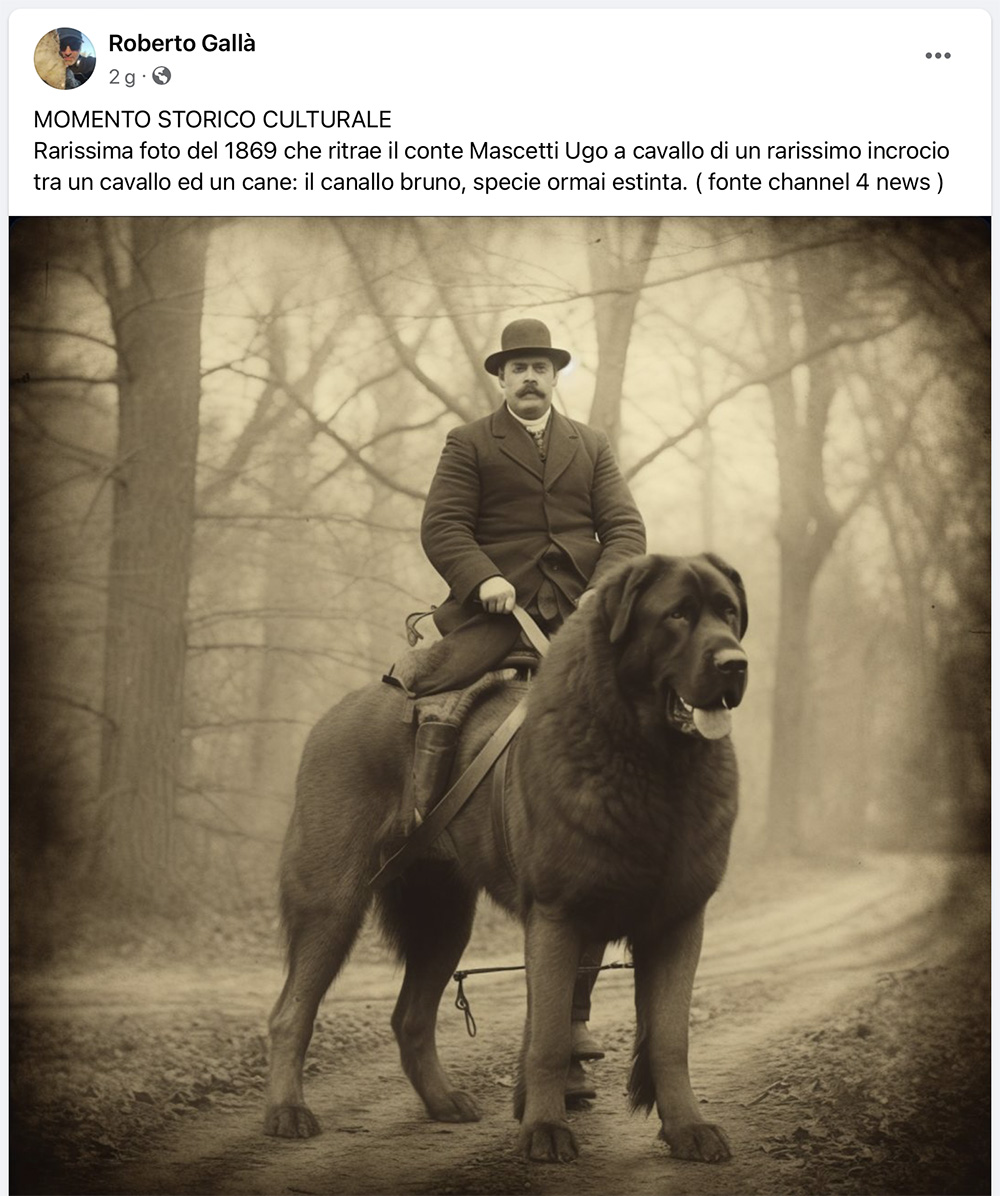

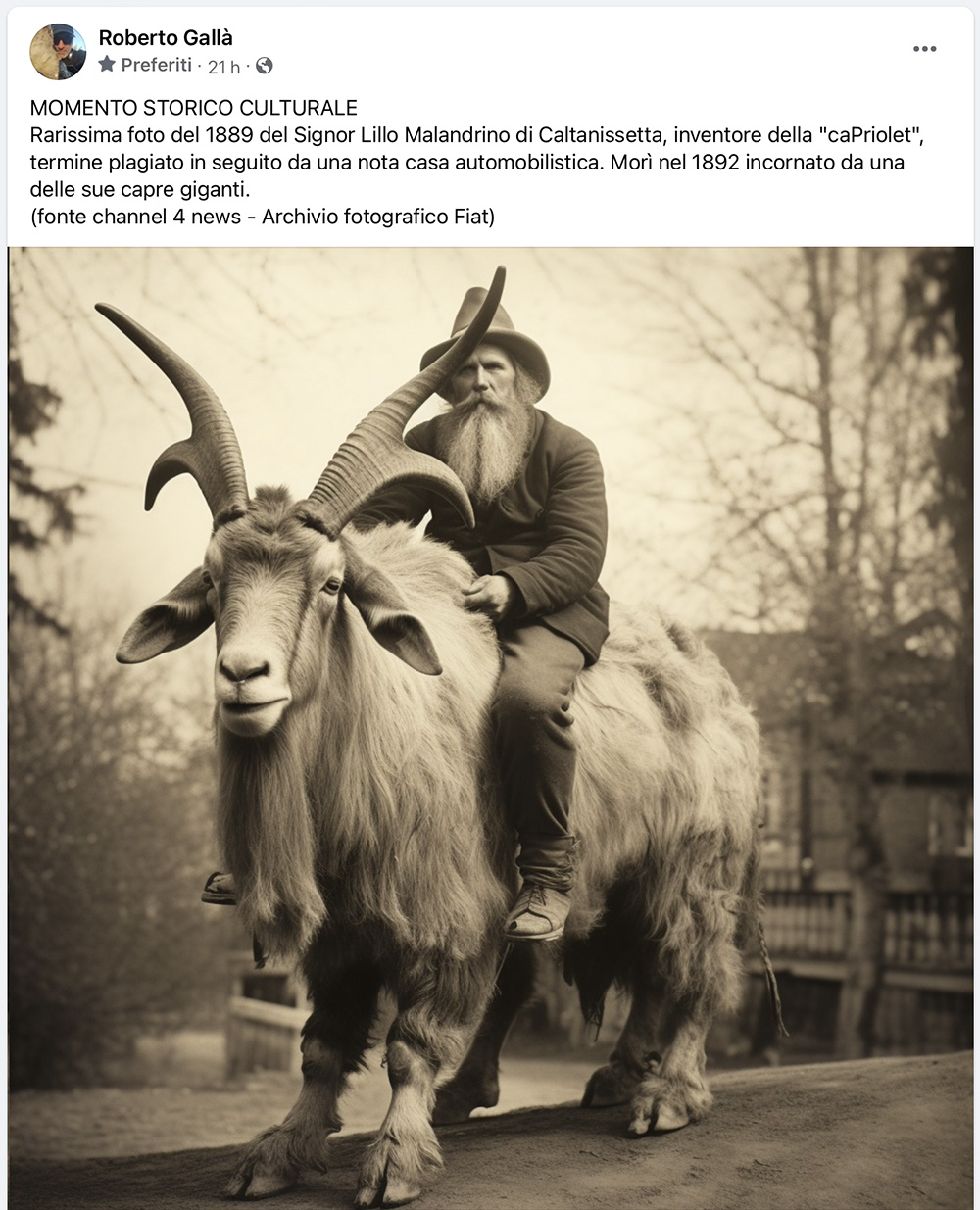

Il mio amico Roberto Gallà, per esempio, per sfottere quegli utenti che periodicamente pubblicano sul loro profilo Facebook la famosa dichiarazione farlocca “Anch’io sto disattivando… appena annunciato su Channel 4 news… Facebook addebiterà a tutti gli utenti a partire da lunedì… non do il permesso a Facebook di addebitare 4,99 dollari al mese sul mio account etc. etc.”, ha creato delle immagini palesemente assurde ma estremamente realistiche, accompagnate da racconti altrettanto paradossali attribuiti alla stessa fonte dell’annuncio clamoroso e cioè Channel 4 news… Insomma delle bufale in piena regola, divertenti e surreali, sulle quali – si spera – neanche il più ingenuo degli utenti potrebbe cascarci!

Per realizzare queste finte foto d’epoca Roberto ha utilizzato Midjourney, un’applicazione di intelligenza artificiale di tipo TTI (text-to-image), cioè in grado di creare immagini partendo da un’accurata descrizione testuale (il prompt).

Queste creazioni, specialmente l’autopo, mi hanno fatto ricordare un esercizio di fotomontaggio digitale che avevo proposto tra le attività creative di Artemondo e cioè creare animali-chimera unendo due specie diverse come quelli dei bestiari medievali, magari dando loro pure un nome: il “pinguatto” con corpo di pinguino e testa di gatto…

… oppure la “aquilaffa“, metà aquila e metà giraffa.

Questi esercizi prevedevano l’uso di Photoshop o altri programmi simili come Gimp o Photopea, anche perché, quando li ho immaginati, non c’era ancora l’IA e occorreva fare tutto a mano. Ma adesso, se non si ha familiarità con il fotoritocco, si può provare con le applicazioni generative. Certo il risultato non sempre è soddisfacente. Uno di quelli che ho usato per creare un nuovo ‘pinguatto’, per esempio, si ostinava ad affiancare i due animali e non c’era verso di farglieli fondere.

È andata un po’ meglio con Canva, anche se gli animali sono un po’ deformi e la fusione appare forzata.

Ad ogni modo, con una buona dose di pazienza e tanti tentativi cambiando le parole del prompt, possono uscire fuori risultati abbastanza simpatici, come questo leone un po’ suino…

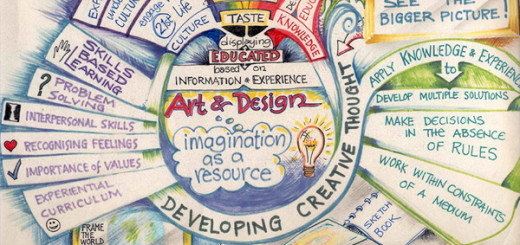

Ma veniamo a un’altro utilizzo intelligente e creativo dell’IA.

Miriam Paternoster, bravissima docente di arte e immagine, ha proposto ai suoi studenti di giocare al cadavere squisito (un gioco collettivo che facevano i surrealisti che consisteva nel creare una frase bizzarra aggiungendo a turno una parola senza però conoscere le parole inserite dagli altri) e poi ha dato in pasto a un programma di IA la frase finale con esiti esilaranti e spiazzanti, in pieno stile surrealista.

Ecco l’illustrazione per “Due postini verdi e un polipo arrabbiato cantano su una scala”

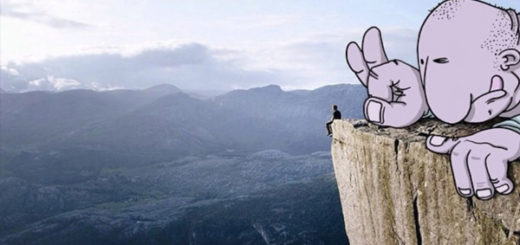

Oppure “Un contadino gigante e un ombrello blu esplodono in montagna”

O anche “Un poliziotto innamorato della sua scopa luminosa ridono insieme sulla spiaggia”.

Straordinario, no?

Questo uso mi ricorda un simpatico canale Telegram intitolato Notizie illustrate da IA nel quale le immagini sono generate usando come prompt il titolo vero di una notizia presa da un quotidiano online, spesso scritto con espressioni idiomatiche che, una volta trasformate in immagini in modo letterale, danno luogo alle scene più folli.

Ma veniamo adesso agli abusi che ho citato nel titolo. Ultimamente sto assistendo a un fenomeno molto preoccupante quando scorro la home di Facebook, soprattutto quando lo faccio dalla pagina Didatticarte (gli amministratori di pagine possono passare dal profilo personale a quello della pagina usandola come fosse quella di un utente).

Ebbene la home è piena, quasi al 100%, di post di pagine alle quali non sono iscritta corredati da immagini fotorealistiche generate dall’IA e accompagnate da frasi pietistiche capaci di muovere decine di migliaia di interazioni, tra like e commenti. Peccato che si tratti di falsi colossali!

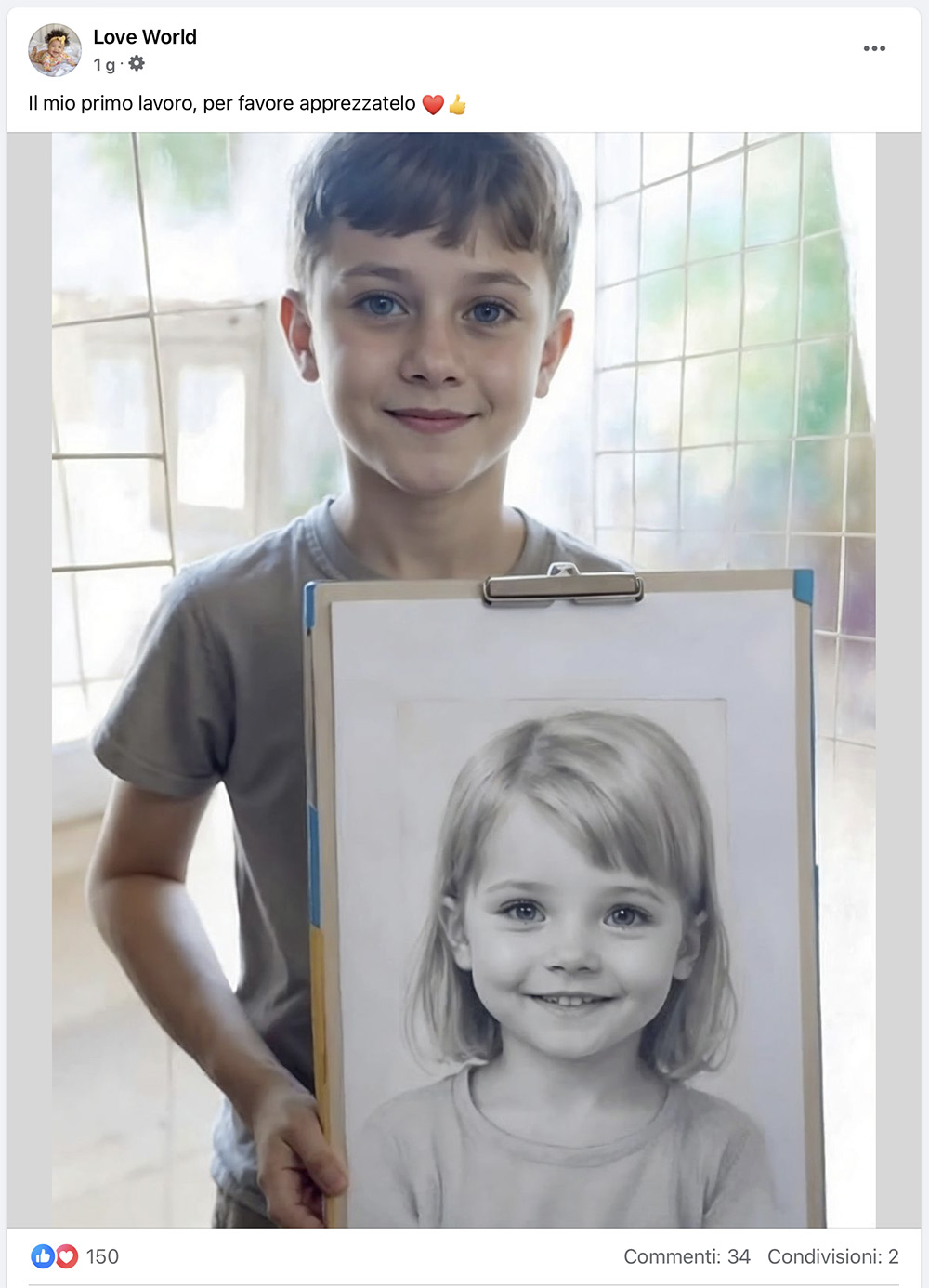

Ecco un esempio tipico.

Oppure quest’altro.

O quest’altro ancora.

Certo, quest’ultimo non sarebbe difficile da sbugiardare: quando mai le angurie crescono nei campi allineate e coperte come soldatini e senza neanche una foglia intorno? Ma a guardare bene anche le immagini precedenti offrono indizi di falsità: basti guardare alle maniche rigide del maglione fatto dalla nonnina o alle anomalie del mobile che sta dietro il tappeto viola.

Per non parlare di certi artisti in erba, davvero inverosimili…

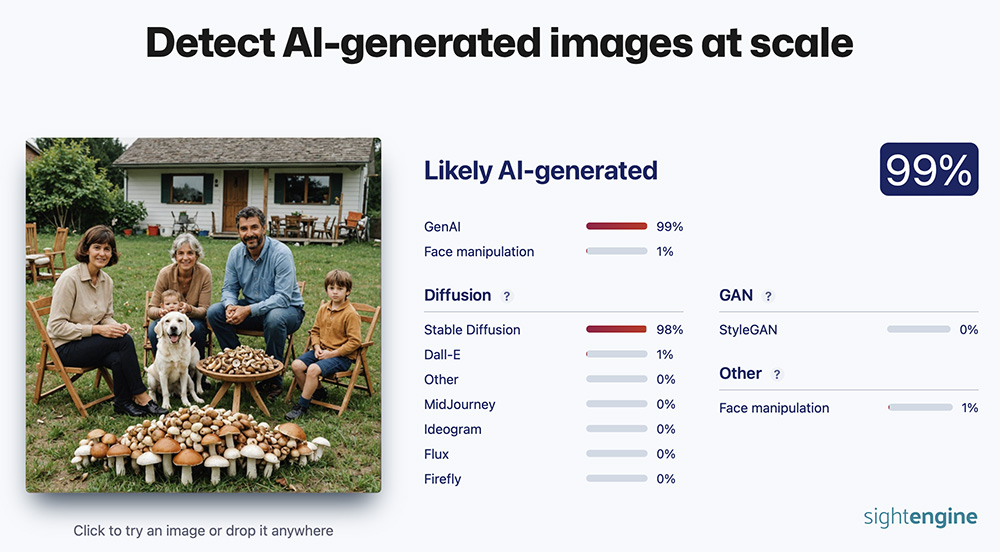

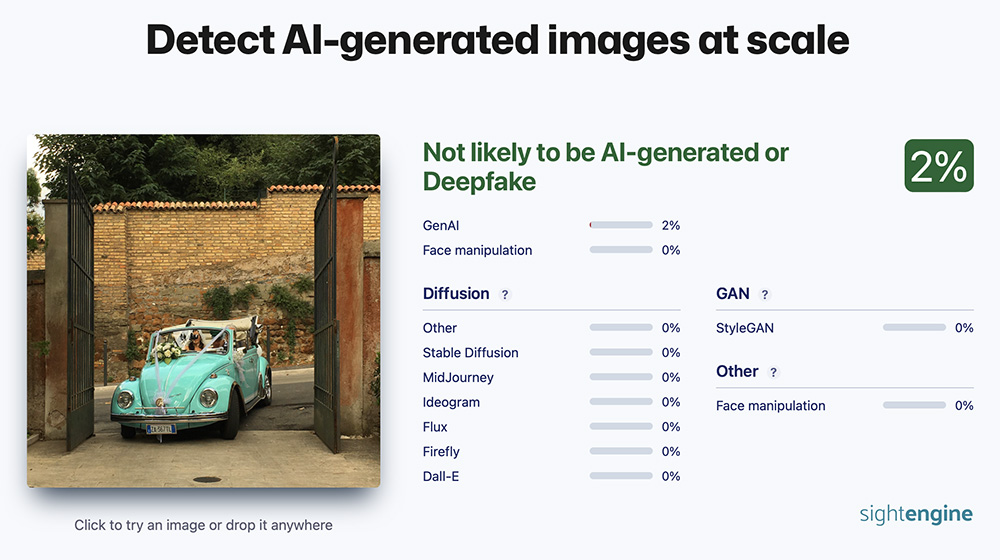

Per avere una maggiore certezza che si tratti di falsi esistono applicazioni come AI image detector, un programma nel quale si può caricare un’immagine sospetta e ottenere una percentuale di probabilità che si tratti di una creazione dell’IA.

Vediamo cosa succede se carico una di queste immagini collegate alla onnipresente frase “Nemmeno un ciao solo perché lavoriamo nei campi“…

Per fare la controprova ho usato una foto scattata da me a una coppia di sposi in Maggiolino turchese.

Come vedete, nel primo caso la probabilità che sia un’immagine digitale è del 99% (ma avete visto quei funghi che stanno in piedi da soli???) mentre per il mio scatto è del 2%. Suppongo che non sia pari a zero per via di piccoli aggiustamenti che ho apportato nel contrasto e nella saturazione della foto, ma la sua autenticità è praticamente certa, così come la falsità dell’altra foto.

Chiaramente si potrà obiettare “Che male c’è a creare delle belle immagini, che raffigurano situazioni di armonia e di serenità, anche se non sono vere?”.

C’è molto di male, non tanto a crearle ma a pubblicarle spacciandole per vere in modo da innescare interazioni a valanga puntando sulla compassione o sulla tenerezza suscitata negli utenti.

Quelle interazioni, infatti, portano guadagni facili agli amministratori attraverso il Bonus Prestazioni di Meta: invece di farli pagare per promuovere i propri post, Meta paga i creatori di contenuti per pubblicare post virali, capaci di trattenere le persone su Facebook per guardare, commentare e condividere.

È una funzione a cui si accede solo su invito per pagine con molti iscritti, indipendentemente dalla qualità dei contenuti proposti (per inciso, quella proposta è arrivata anche a me ma l’ho ignorata).

Dunque mettere un like a questi post non fa altro che portare guadagni a persone senza scrupoli che distribuiscono contenuti falsi. Per rendere anche più credibile le buone intenzioni, quelle pagine hanno spesso titoli che rimandano alla sfera religiosa come “Gesù ti benedica”, “Ave o Maria”, “Nostra Signora di Lourdes”, “Grazie a Dio” e simili.

È chiaro che queste pagine puntano su un certo tipo di utenza, meno scafata nell’individuare i contenuti falsi, ma è anche vero che il realismo delle immagini generate con l’IA mette alla prova anche il navigante più smaliziato. Non fosse per quelle frasi stucchevoli con cui si accompagnano queste foto, sarebbe difficile capire che sono immagini digitali di persone che non esistono.

Ma fino a qui potremmo dire ancora che il problema è relativo: tutto sommato fare i complimenti a un contadino immaginario e far guadagnare con questo gesto qualche tizio poco onesto non è un dramma. Il problema si pone nel momento in cui queste immagini si vanno a sostituire a fatti e luoghi reali, raccontando così delle grandi fandonie. È il caso, giusto per fare un esempio, dell’antico ninfeo della città romana di Sagalassos, in Turchia, che viene presentato in un post con una fotografia di pura invenzione creata con l’IA.

Ed ecco l’immagine reale di quel luogo.

Ovviamente questo avveniva anche in passato per esempio con dipinti falsi attribuiti a grandi artisti (ne ho sbugiardati un po’, dal Vento di van Gogh alla donna di Bouguereau) o con foto di eventi pieni gente usate per mostrare un evento molto meno affollato (dai comizi ai concerti).

Con la ricerca inversa era relativamente facile scoprire il falso. Tuttavia in pochi facevano quella verifica. Figurarsi adesso che queste immagini non sono rintracciabili perché mai usate in precedenza… Certo, ci sono le applicazioni di verifica, ma chi le userebbe?

Questi sono solo piccoli esempi che però ci possono dare un’idea di come si stiano perpetrando enormi truffe e di come sia possibile arrivare anche a manipolare l’opinione pubblica su temi sensibili usando un’arma così potente.

Non è questo il posto per approfondire queste implicazioni e io non sono una ricercatrice del campo (per saperne di più rimando a questo studio), ma nel mio piccolo osservo con una certa inquietudine gli sviluppi dell’Intelligenza artificiale visiva e invito tutti a usare sempre tanto, ma proprio tanto spirito critico.

Sempre molto interessante il tuo intervento, stimolante con tante idee operative. Complimenti e grazie

Chiarina

Ti ringrazio tanto!

Grazie, articolo interessantissimo e grazie per il link allo studio.

Posso chiederle cosa pensa del diritto d’autore? Se qualcuno mi chiede un’immagine in alta risoluzione da mio ipotetico fondo fotografico, io gliela fornisco a pagamento oppure gratuitamente chiedendo di citare il credito; cosa gli impedisce di ricrearla con l’IA e di dirmi che non mi deve nulla? Scusi la lunghezza, magari ha già scritto a questo proposito

Salve Simona, grazie per l’apprezzamento. Quanto al diritto d’autore ho molte preoccupazioni. Fotografi, illustratori e artisti possono essere copiati facilmente senza che neanche lo sappiano. Spero si trovi presto qualche modo per proteggere la creatività ‘naturale’, quella scintilla che decine di migliaia di anni fa ha fatto tracciare sulle pareti di una roccia l’inizio di una grande storia.

Sei straordinaria!

Addirittura! Grazie 🙂

Grazie, articoli sempre interessantissimi!!

🙂

Molto interessante

Ti ringrazio, Marino.

Grazie Emanuela di questo articolo. Come tu affermi chi è nel settore dell’arte la deve fermamente proteggere. Ben venga la fantasia Ai ma è altro. Marinella

Grazie dell’apprezzamento, Marinella.